Cursos e Produtos

Últimos tutoriais

Últimos Downloads

Galeria dos Membros

sujeira no \" substance designer \"

estou aqui com um problema nas normais quando usa um modelo cheio de meshes do max para o substance designer

eu unifico e reverto as normais de todas as meshes juntas no max mais o substance inverte as normais que estavam boas antes de aplicar o modifier normal

como eu posso tornar as normail destas varias meshes juntas de uma só vez ?

ou eu tenho de fazer isso mesh por mesh ?

outra coisa : eu só consigo ver se as normais da mesh estão corretas quando eu exposto no substance designer

eu estou modelando no Rhino

e estou exportando no .3DS

Pelo visto a resposta que postei para você foi perdida, sinto muito, é difícil aturar internet, mas vou responder novamente nesta mensagem.

Sobre a exportação dos mapas, eu entendi a pergunta, por isso que na mensagem anterior expliquei como fazer um gráfico para exportar apenas a máscara e o Normal Map no Substance, se quiser pode até deletar os Nodes do Normal Map e exportar somente a máscara.

Com a máscara pronta você vai criar os materiais normalmente no 3ds max e usará o material Blend para misturar os dois aplicando a máscara, assim, vai exibir um dos materiais só nas Edges e o outro no resto da superfície, como expliquei na outra mensagem.

Foi desta forma que eu fiz o Rhino robô.

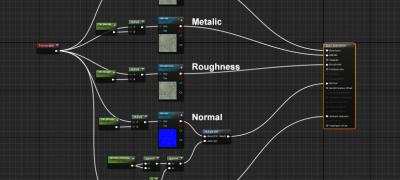

Se você fizer o material completo no Substance Designer terá que exportar todos os mapas como Base Color, Normal, Roughness, Metalic e qualquer outro canal que criar.

Imagine se resolver trocar a cor da pintura, terá que voltar no Substance e exportar tudo de novo, mas se o material for feito no próprio Max é só ajustar lá mesmo, então, acaba sendo muito mais prático usar somente a máscara, entende?

Sobre os programas que trabalham bem com Substances, todos os programas 3D atuais possuem as mesmas funcionalidades do 3ds max e alguns são bem melhores como o Houdini, mas não vale a pena trocar de programa apenas por causa dos Substances, pois vai levar um bom tempo para fazer tudo que faz com a mesma desenvoltura.

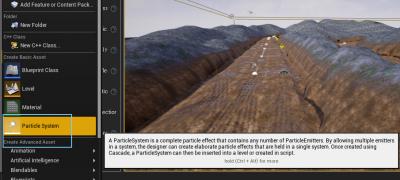

Teria vantagem se fosse mudar par a Unreal ou Unity, porque dai o render seria em tempo real e isso faz uma grande diferença.

Neste caso as animações continuariam sendo feitas no 3ds max e depois seriam exportadas para a Unreal, onde iria iluminar, texturizar e animar a câmera.

Certamente terá mais qualidade gráfica do que o Scanline.

Se você quiser tentar, pode contar comigo que te ajudo em tudo que puder.

Sobre o Marmoset, ele é equivalente ao render da Unreal com um pouco menos de qualidade no sombreamento, mas o sistema de animação dele ainda é muito precário, aceita somente PRS (Position, Rotation e Scale), então, não é adequado para animação de verdade.

Mas é uma boa opção para imagens estáticas, a partir da versão 3 tem sampleamento para interiores, então, tanto faz se é cena interna ou externa e o cenário pode conter diversos personagens e objetos, só depende da sua placa de vídeo.

Abração e tudo de bom.

André Vieira

qual teria melhor qualidade de imagem : Unreal ou Unity

em um detes dois existe render para capture com uso do processador ?

minha placa de video , GeForce GTX 960 - 2GB memoria , da conta destes programas ?

eu consigo usar todos os recursos ?

quero lembrar que não vou usar para animação

só uso para imagens estaticas

estes programas tem a edição da cena toda em real-time ?

não tem aquele negocio de calcular a iluminação né ?

Oi Abílio, tudo bem?

Agora vou responder a mensagem sobre as Normals.

Este problema é bem comum de acontecer, ainda mais se modela em programas de CAD e exporta em formatos antigos como 3DS.

Cada face do Mesh tem a sua Normal, se você importar várias partes de um objeto com Normals opostas e soldar tudo no Max, vai ter problemas, vai precisar inverter as Normals manualmente.

O ideal é primeiro verificar a direção de todas as Normals, editar se necessário e só depois soltar os vértices formanto um único Element do Mesh.

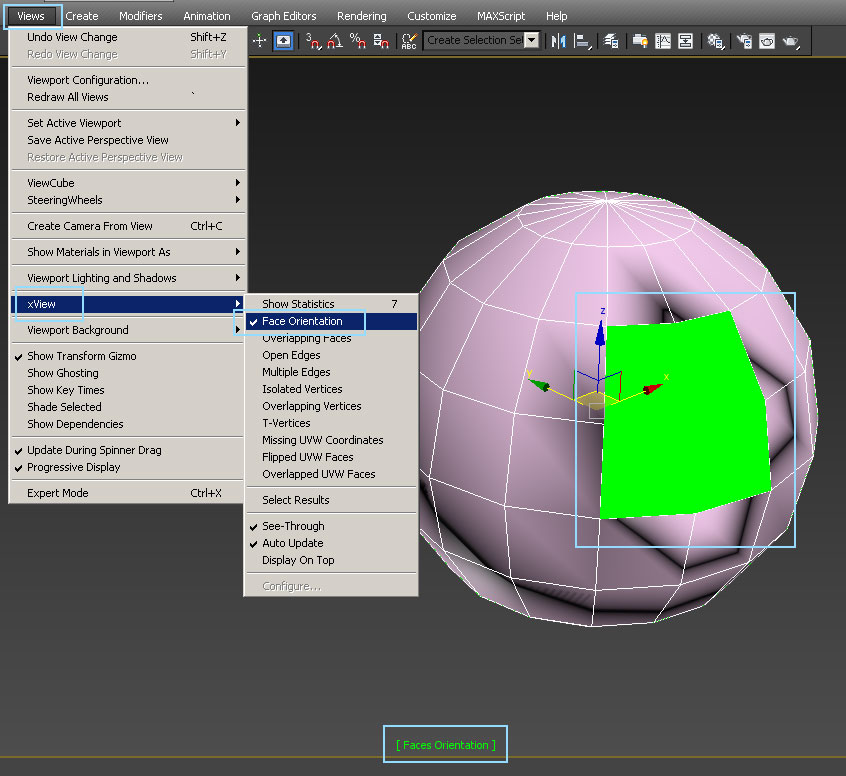

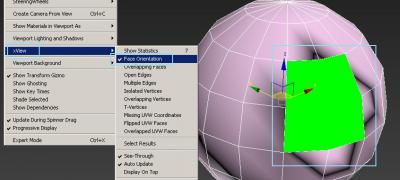

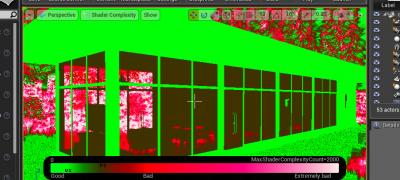

Tem várias formas de você visualizar e verificar erros de Normal no Max, eu acho que a melhor opção é o xView, que você encontra no menu Views > xView.

Dentro dele tem a opção Face Orientation para exibir as faces com Normal invertida, como mostra a primeira imagem em anexo onde as faces aparecem em verde.

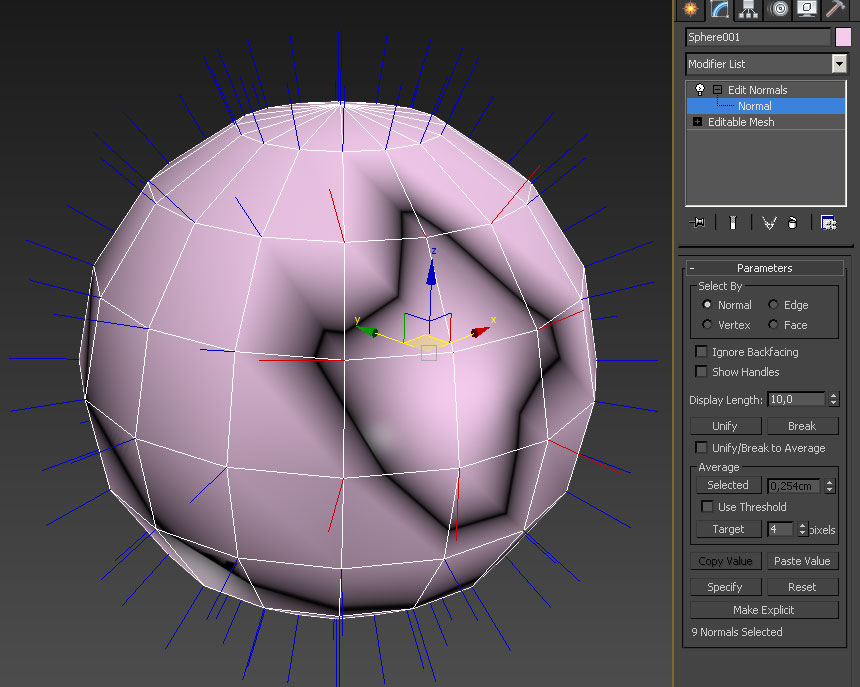

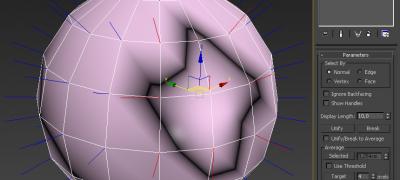

A outra forma é aplicar o modificador Edit Normals, como mostra a segunda imagem em anexo.

Eu selecionei as Normals que estão na direção errada para aparecerem em vermelho, note como elas apontam para direções diferentes das demais.

O Edit Normals permite que você rotacione as Normals manualmente para ajustar como quiser, mas não é prático fazer isso.

Eu acho que a forma mais prática é aplicar o modificador Normal e habilitar o Unify Normals, mas nem sempre resolve, ainda mais com objetos importados.

Então, se não resolver você precisa usar o comando Flip do Editable Mesh ou Editable Poly para inverter manualmente as faces mostradas em verde pelo xView.

Ainda tem outro problema que pode apresentar o mesmo efeito de Normal invertida no Substance e nas Engines de Games, que é o UV invertido, você também consegue verificar isso através do xView usando a opção Flipped UVW Faces.

O xView é muito útil, ele mostra diversas coisas importantes como sobreposição de mapeamento, vértices soltos, Edges abertas, entre outros.

Abração e tudo de bom.

André Vieira

Sobre a qualidade gráfica das Engines, é difícil dizer, pois tem certos detalhes em cada uma que faz muita diferença dependendo do que a pessoa pretende fazer.

Para te dar um bom exemplo, a Unreal tem muito mais recursos de materiais e normalmente obtém um ótimo resultado, mas se quiser que o GI da cena se altere em tempo real vai precisar usar o Light Propagation Volumes (LPV) que é uma porcaria.

Já a Unity tem poucos recursos de materiais e fica difícil criar certos tipos de efeitos, pois depende de escrever um Shader para fazer o que você deseja, mas por outro lado ela tem o Enlighten, que é muito melhor do que o LPV e consegue alterar o GI em tempo real com qualidade.

Nesta semana eu vou postar uns testes de maquete interativa que fiz na Unity e Unreal para mostrar justamente esta questão do GI Real-Time.

Para maquete é muito importante um bom GI Real-Time, mas os materiais são ainda mais importantes, então, normalmente as pessoas escolhem a Unreal, mas para outro tipo de projeto tem que verificar bem qual é a melhor opção.

Agora, se você não vai animar, a vantagem de exportar para a Unreal não é tão grande, pode ser que você consiga resultados muito semelhantes usando o Marmoset Toolbag, que é bem mais simples.

As Engines normalmente precisam fazer o Bake da iluminação para rodar em Real-Time, mas também tem diversos recursos que você pode usar diretamente em Real-Time sem precisar de Bake, se quiser iluminar a cena toda apenas com luzes Real-Time você pode, porém, não vai ter o Color Bleed do GI, apenas a iluminação global gerada pela Skylight.

O Bake da iluminação é muito mais veloz do que uma renderização convencional, adiciona qualidade gráfica na cena e depois de pronto permite tirar quantas imagens ou vídeos quiser sem ter que renderizar nada.

Eu acho que você deveria testar o Marmoset Toolbag, pode ser o que você precisa para fazer o seu projeto com mais eficiência e praticidade.

A sua placa de vídeo é boa para cenas Real-Time, eu fiz os exemplos de maquete interativa que falei que vou postar usando uma GTX 250.

Assim que terminar de responder este tópico vou postar um vídeo na seção Dicas e Grupos de Estudo do rig de carro com suspensão aparente que fiz na Unreal usando a GTX 250.

Abração e tudo de bom.

André Vieira

obrigado pela ajuda

quando agrupa varias meshes atravez do material editor do max

para facilitar a seleção no substance

como se faz o bake no substance destas varias meshes juntas ?

eu queria fazer substancias em todo este objeto na viewport do substance designer de uma só vez

com substancias diferentes em cada grupo feito no material editor no max

mas usando o node triplanar que nessessita de bakes e outros bakes

é possivel ?

É perfeitamente possível, só precisa planejar direito.

Veja só, você pode ter um objeto feito de apenas uma peça como um Box, por exemplo, e ter vários materiais aplicados neste Box usando um ID diferente para cada face dele, pois dai você cria um material Multi/Sub-Object no Max com o mesmo número de IDs e cada material vai ser aplicado na face com o ID correspondente, certo?

Se este Box for bem mapeado com o Unwrap UVW para que nenhuma face fique em cima de outra face, tudo vai funcionar bem em qualquer programa.

Agora, se você cria outra peça, por exemplo, outro Box, e quiser anexar no primeiro Box para os dois serem um único objeto, não adianta agrupar, tem que usar o Attach do Editable Mesh ou Editable Poly para realmente anexar os dois.

Porém, neste caso o mapeamento do segundo Box será colocado em cima do mapeamento do primeiro Box, é só aplicar o Unwrap UVW e abrir o Editor dele para ver que os dois mapeamentos estarão sobrepostos.

Então, se você ajustar o mapeamento para não deixar nenhuma parte em cima de outra, tudo vai funcionar bem.

Normalmente é só usar o Tools > Pack UVs no menu superior da janela do Editor do Unwrap UVW para ele arrumar as peças automaticamente.

Você pode exportar o FBX com vários objetos separados ou unidos com o Attach, contendo um ou mais materiais, para funcionar direito só precisa mapear direito e aplicar materiais com nome em cada Face ID, pois é pelo nome que vai identificar no Substance Designer.

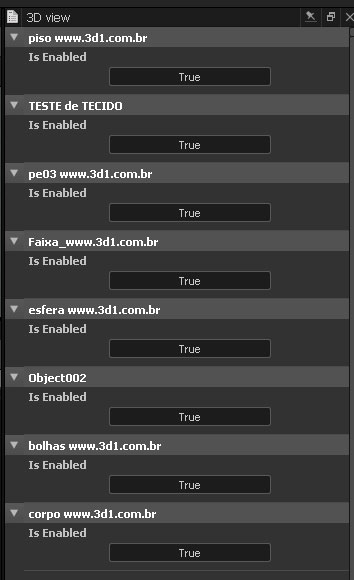

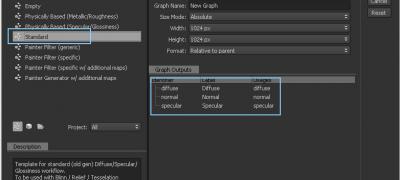

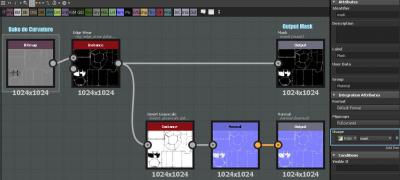

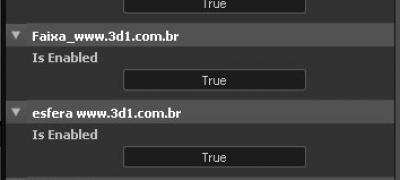

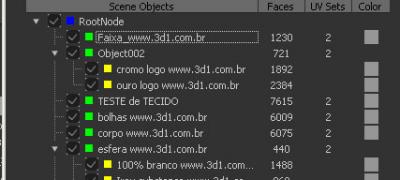

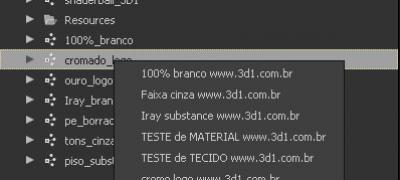

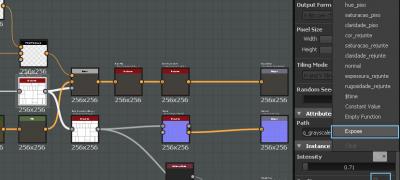

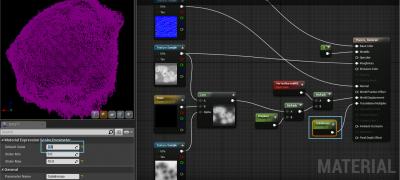

Quando importar o modelo no Substance, cada objeto pode ser ligado ou desligado visualmente na cena clicando no Scene que aparece logo acima da vista 3D, dentro dele tem o Edit que exibe a primeira imagem que estou enviando em anexo.

Ela mostra todos os objetos que estão no arquivo FBX e você pode ligar ou desligar no Enable.

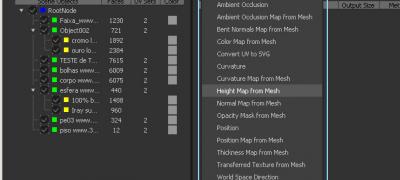

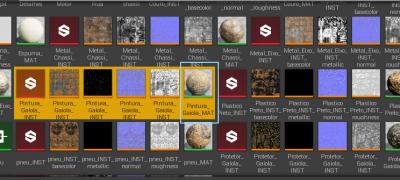

Acessando a janela de Bake você também vai ver em verde os objetos separados e ainda vai ver em amarelo os materiais Multi/Sub-Object que aplicou, então, você pode habilitar e desabilitar os objetos que vai fazer o Bake, pois se fizer o Bake de dois objetos independentes ao mesmo tempo será igual dar Attach no Max e sobrepor os dois mapeamentos.

A segunda imagem em anexo mostra o Bake com vários objetos.

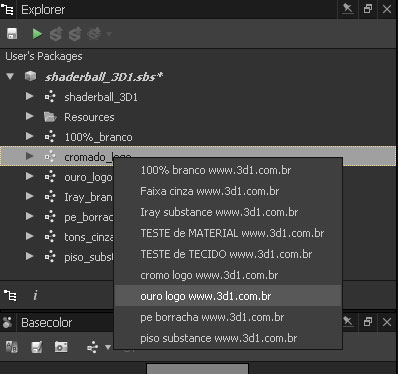

Baixe o Shaderball que fiz para o Substance e poderá testar com ele, foi gravado no SD 5, está nesta página: http://www.3d1.com.br/recursos/215/shaderball-substance-designer

É o mesmo arquivo que usei para pegar estas imagens para te mostrar.

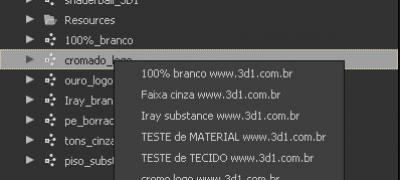

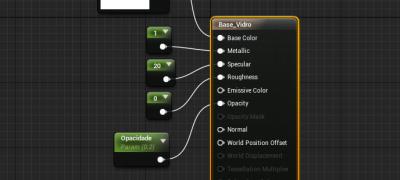

No Substance Designer você pode criar vários Graphs onde cada um é um material, os Graphs ficam listados dentro do seu Substance no canto superior esquerdo da tela, dando dois cliques em cada Graph aparece a lista dos materiais aplicados nos objetos lá no Max e você pode escolher qual vai aplicar o material do Graph selecionado, como mostra a terceira imagem em anexo.

A outra pergunta eu vou responder na próxima mensagem.

Abração e tudo de bom.

André Vieira

Sobre o Rhinoceros eu não vou poder ajudar muito, faz muitos anos que não uso ele, o Diego Dneo é mais adequado para te responder isso, ele é o professor do curso de Rhino e ajuda todo mundo com prazer, chama ele no Chat quando ver que está logado, o nome dele aparece em vermelho por ser parceiro da 3D1.

Agora, eu sei que o Rhino já aplica um mapeamento nos objetos, cada face já vem mapeada, mas fica tudo separado no Max, então, tem que unir as partes com o Stitch do Unwrap UVW, pois quanto menos emenda tiver no mapeamento, será mais fácil para trabalhar e ficará melhor.

Agora, se estas partes do objeto não estão soldadas de verdade, não vai conseguir unir os mapeamentos, então, primeiro tem que selecionar todos os vértices e dar um Weld com valor bem baixo para soldar apenas os vértices sobrepostos e não os vértices próximos.

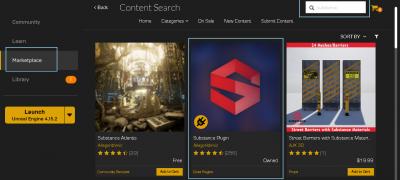

Sobre a Unreal, você não vai trabalhar com arquivo 3DS, vai trabalhar com FBX.

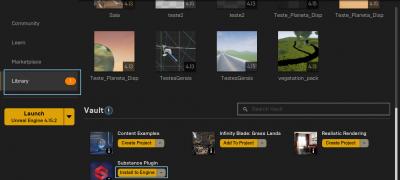

Basicamente vai importar o FBX na Unreal, depois vai importar os Substances, automaticamente os Substances vão gerar mapas e materiais prontos para usar, não é a forma mais eficiente de fazer, mas é a mais fácil, depois que pegar o jeito eu te ensino a fazer da outra forma.

Dando dois cliques no FBX que aparece no Browser da Unreal vai abrir uma janela com ele e a lista de materiais com os nomes que definiu no Max igual apareceu no Substance.

É só clicar em cada material e escolher na lista o material criado pelo Substance.

A primeira imagem em anexo mostra essa janela da Unreal.

Porém, tem uma coisa muito importante para a iluminação funcionar bem nas Engines, precisa de um segundo canal de mapeamento que é usado pela iluminação, as Engines podem criar este segundo canal automaticamente, mas será a mesma coisa que aplicar um Unwrap UVW com o Flatten automático, que separa o objeto em muitas partes e é justamente isso que causa defeitos no Bake da iluminação.

Só que você já teve que fazer um bom mapeamento para texturizar bem no Substance, então, é muito simples e fácil ter um bom segundo canal de mapeamento para iluminar sem problemas na Unreal.

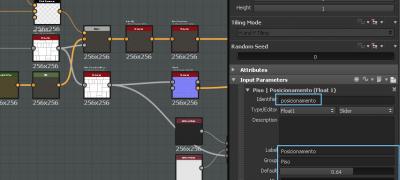

Logo que terminar de fazer o mapeamento no 3ds max, aplique outro Unwrap UVW em cima do que usou para mapear e mude o Map Channel dele para 2, quando fizer isso vai aparecer uma mensagem perguntando se deseja mover ou abandonar o mapeamento que já tem, é só clicar no Move e pronto, terá uma cópia do primeiro mapeamento no segundo.

Em seguida é importante colapsar tudo para não deixar os dois Unwrap UVW no Edit Stack, pois pode dar problema na exportação do FBX, ficando com apenas um mapeamento.

Então, clique com o botão direito na Viewport, escolha o Convert To > Editable Mesh e pronto, pode exportar o FBX.

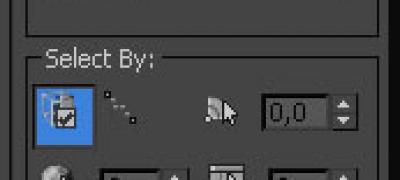

A segunda imagem em anexo mostra o Edit Stack com os dois Unwrap e o Map Channel 2 no segundo.

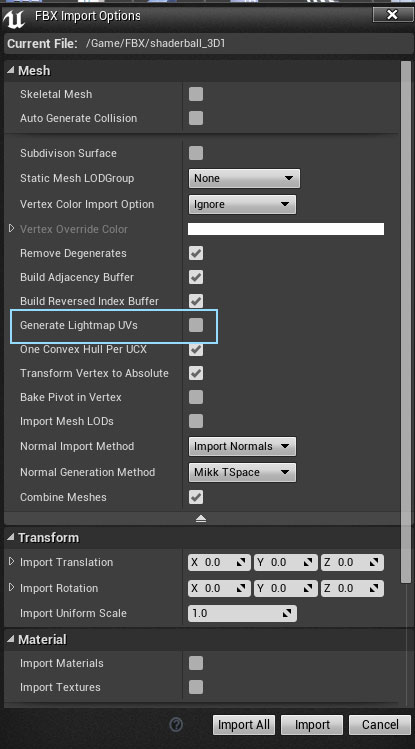

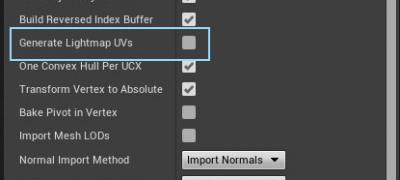

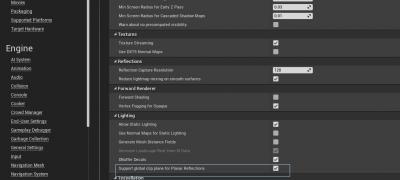

Quando for importar na Unreal tem que desmarcar a opção Generate Lightmap UVs, para poder usar o que você fez em vez de criar um novo automaticamente.

A terceira imagem em anexo mostra a janela de importação da Unreal.

Abração e tudo de bom.

André Vieira

e os materiais :

eu tenho acesso aos controles dos materiais do unreal engine no substance designer ?

no caso do segundo canal de mapeamento que é usado pela iluminação do unreal

eu ja devo mandar as meshes para o substance designer com os dois canais ?

voce não respondeu esta :

no unreal engine existe render para capture com uso do processador ?

quero lembrar que não vou usar para animação

só uso para imagens estaticas

Os mapas criados no Substance normalmente têm no máximo 4K, então, são grandes, mas não são imensos, se tiver memória na placa de vídeo poderá usar alguns mapas com 4K.

A Engine utiliza uma versão comprimida da textura que pode ser acessada rapidamente pelo Render, também altera a resolução da textura automaticamente conforme a distância da câmera, recurso conhecido por MipMaps.

Isso acontece também com a malha 3D dos objetos, se for criar um cenário muito grande para rodar em Real-Time você precisa criar versões dos objetos com menos polígonos para serem vistos de longe, assim, a Engine exibe cada versão conforme a distância da câmera, então, apenas os objetos próximos serão exibidos com todos os polígonos, os objetos distantes são mais simples, mas com o efeito de DOF na câmera para desfocar objetos distantes, acaba não percebendo os detalhes dos objetos distantes e fica perfeito.

Sobre o controle dos materiais da Unreal no Substance Designer, acho que você quis dizer o oposto né?

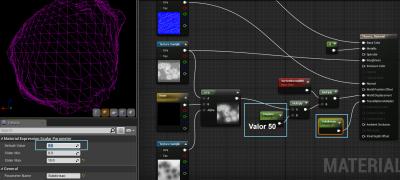

Você poderá controlar os recursos do material Substance dentro da Unreal em tempo real e se quiser até durante uma animação ou um jogo.

Poderá aplicar texturas nos Slots de Input de imagens, coisa que é impossível no 3ds max, pode randomizar automaticamente todos os recursos do material ou os recursos que definir, é incrível!!!

Olha o vídeo que postei no tópico, o material do planeta foi criado no Substance e aplicado numa esfera na Unreal, a janela do lado esquerdo mostra os controles do material Substance dentro da Unreal e a janela do lado direito mostra o material da Unreal e a esfera de amostra.

Posso mudar qualquer parâmetro no material Substance que automaticamente se reflete no material da Unreal e na esfera de amostra.

Agora, para acessar os parâmetros do Substance na Unreal ou em qualquer outro programa você precisa expor os parâmetros lá no Substance Designer.

Mas se você não vai animar, se quer ver o resultado em tempo real apenas para ajustar corretamente os materiais, poderá fazer isso normalmente no Substance Designer, pois ele tem visualização em tempo real similar ao sistema das Engines e se quiser ainda pode renderizar com Raytrace interativamente usando o Iray no próprio Substance Designer.

Sobre o segundo canal de mapeamento, pode enviar para qualquer lugar já com o segundo canal de mapeamento, pois facilita o processo, não precisa exportar duas vezes e não interfere em nada nos demais programas, todos vão usar o canal 1 para as texturas.

Sobre a pergunta que não respondi, desculpe, esqueci de te falar que eu não entendi.

O que quis dizer com "render para capture com uso do processador"?

Abração e tudo de bom.

André Vieira

Faça o login para poder comentar

VOCÊ TAMBÉM PODE SE INTERESSAR POR:

Informações da Comunidade

Total de mensagens publicadas pelos membros da comunidade: 713186.

Total de membros registrados: 140358

Últimos membros registrados: sgengenharia, Outenrebecs, Vincemberger, profunction, CuralisCBDKapsler, purivakopen, CuralisCbdCapsules2025, Naitoran.

Usuário(s) on-line na última hora: 664

Legenda: Administrador, Especial, Moderador, Parceiro .

.jpg)